스탠포드 강의를 듣고 있는데, 이 부분은 어렵게 표현하려고 안달난 것 같다.

gpt를 보고 어느정도 이해했다고 생각해서 정리할 겸 올린다.

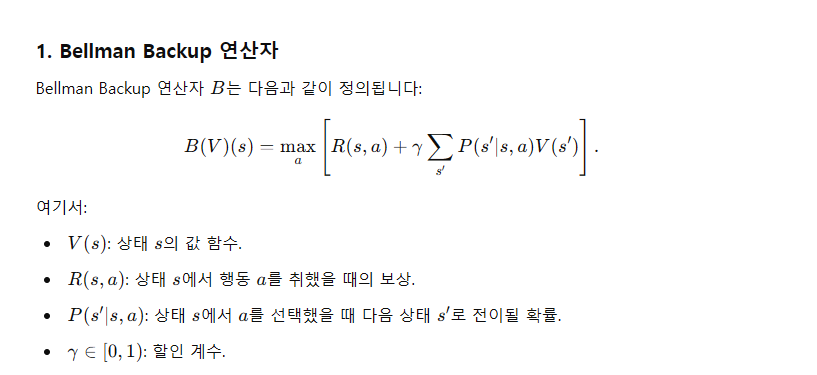

즉 B라는 연산은 현재 상태에서 할 최적의 행동을 고르는 것이다.

여기서 최적이라는 것은 기댓값 처럼 사용해서 구하는데 위에 식에서 보이는 확률이 곱해진 느낌이다.

value iteration이라는 것은 이러한 Bellman Backup을 반복적으로 시행하는 것이다.

그냥 dp[s] -> s상태에서 갈 수 있는 최적의 값

이라고 두면 R(s,a)-> 행동에 대한 보상이니까 대충 확률 dp 느낌? 으로 전이된다. 감마씩 곱해지는게 느낌은 비슷한 것 같다.

결국 반복과정에서 수렴하는지를 살펴봐야 한다.

수렴할까?

증명 순서는 다음과 같은데

1. B가 축소 사상이다.

2. 축소 사상은 수렴한다.

3. 수렴된 건 유일?

r<1 일로 정의되므로 축소 사상인 건 쉽다.

수렴하는 이유는 직관적으로 생각하면, 점들이 모인다고 생각하면 편하다.

조금 더 자세한 증명은 Banach의 고정점 정리를 통해 하면 된다.

유일한지는 어떻게 보일까?

이런 느낌으로 한다고 한다.

어떻게 보면 가장 생각하기 쉬운? method 인 것 같기는 하다. 수렴성만 보이면..

'CS > Artificial Intelligence' 카테고리의 다른 글

| WHERE DID ALL THE MEMORY GO? (0) | 2025.02.03 |

|---|---|

| Pipeline Parallelism - Weight Stashing / Vertical Sync (5) | 2025.01.31 |

| Non-Autoregressive (NAR) (0) | 2025.01.20 |

| Purpose of Regularization (1) | 2025.01.06 |

| Cross entropy Loss에서 gradient 구하기 (5) | 2024.11.10 |